FONIC Bessere Suchfunktionen durch KI: Beantworten von Kundenfragen mit einer RAG Applikation

Telefónica und inovex arbeiten seit vielen Jahren an der (Weiter-)Entwicklung des Kundenportals von der Mobilfunkmarke FONIC. Der Fokus liegt dabei auf der Zufriedenheit der User und der stetigen Verbesserung des Portals – sowohl technisch als auch im Hinblick auf die User Experience. Durch den Einsatz innovativer Technologien, wie Generative AI, möchte FONIC seinen Kund:innen eine bessere Erfahrung bieten und sich damit klar im Markt positionieren.

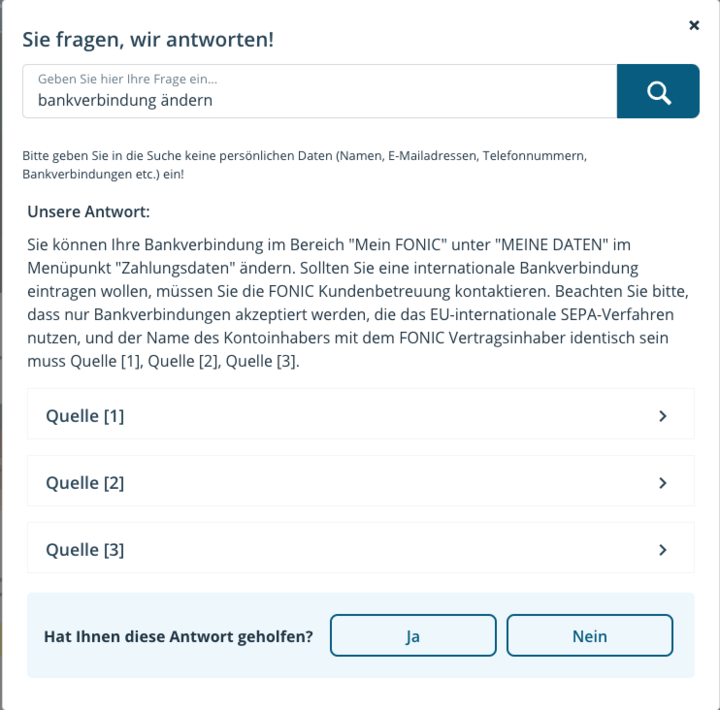

Zusammen mit inovex sollte aus diesem Grund das bisherige FAQ-System von FONIC durch eine RAG-Lösung (Retrieval Augmented Generation) ersetzt werden. So können User ihre Fragen direkt in ein Chat-Fenster eingeben und bekommen passgenaue Antworten. Dadurch kommen Kund:innen 10-mal schneller an ihr Suchziel. Gleichzeitig erkennt das System, wenn Informationen für genaue Antworten fehlen, sodass diese im Nachgang ergänzt werden können. Im Vergleich zur früheren FAQ-Lösung liefert das KI-gestützte RAG-Tool präzisere Antworten, verringert den Aufwand für die Nutzer:innen und vereinfacht die Pflege sowie Erweiterung des hinterlegten Wissens.

Motivation und Status Quo

In Mobilfunkportalen können komplexe Abläufe bei Kund:innen Fragen aufwerfen. Als Lösung bietet das FONIC Portal ein FAQ-System an, das Antworten und weiterführende Fragen basierend auf der User-Eingabe vorschlägt. Dabei greift es auf Wissen zurück, das in einer Baumstruktur hinterlegt ist. So gelangen Nutzer:innen über mehrere Teilschritte an die Informationen, die sie benötigen.

Eine ausführliche Untersuchung des Nutzerverhaltens mit dem bestehenden Frage-Antwort-System hat ergeben, dass Nutzer:innen den Prozess mit kurzen Schlüsselwörtern oder Phrasen starten. Daraufhin werden Vorschläge genutzt, um detaillierte Fragen zu beantworten. Die Daten dieser Aktionen haben ergeben, dass User im Durchschnitt etwas mehr als zwei Interaktionen benötigen, um zu einer zufriedenstellenden Antwort zu kommen oder den Prozess abzubrechen.

Dies hat zur Folge, dass etwa 4000 Kund:innen monatlich keine klare Antwort bekommen. Viele dieser User kontaktieren daraufhin den Kundensupport – ein unnötiger Mehraufwand für Kund:innen und FONIC.

Identifikation von Wissensquellen

Um die vorhandenen Prozesse zu vereinfachen und nutzungsfreundlicher zu gestalten, haben inovex und FONIC in ihrem Portal vier verschiedene Quellen identifiziert, die Wissen rund um Produkt und Prozesse enthalten.

Die offensichtlichste Quelle sind die FAQ-Seiten, die für viele Themen bereits Frage-Antwort-Paare bereitstellen. Durch das FAQ-Format sind diese Dokumente ideal dazu geeignet, als Wissensbasis für eine RAG-Applikation verwendet zu werden.

Als zweite Quelle dient das Prozesswissen, das in der Baumstruktur des bisherigen Systems hinterlegt ist. Dabei handelt es sich um Hilfestellungen, Anleitung und Problemlösungen rund um das Kundenportal. Um dieses Wissen für eine RAG-Applikation zu nutzen, sind einige Verarbeitungsschritte notwendig. Durch Baumtraversierung können alle möglichen Interaktionsstränge extrahiert werden. Diese wurden mithilfe des Modells GPT-4o auf die Kernaussagen zusammengefasst und als Anleitung umformuliert. Die daraus entstehenden Dokumente werden Teil der Wissensbasis für die RAG-Applikation.

Als weitere Informationsquellen dienen SEO- und Informationsseiten (HTML) und Dokumente, die als PDFs bereitgestellt werden, wie AGBs und Preislisten.

Technische Umsetzung

Der Wunsch von FONIC war es, dass Anfragen besser und schneller beantwortet werden. Für diese Anforderungen hat sich GPT-4o als bestes Modell herausgestellt, da es in unter 3 Sekunden bessere Antworten als das bisherige FAQ-System bietet.

Die RAG Pipelines wurden mit dem Framework Haystack 2 implementiert, da es bereits viele vorgefertigte Schnittstellen zu Azure bietet, um dort Services wie OpenAI-Modelle und ElasticSearch zu verwenden. Für die Dokumentensuche wurde ein hybrider Ansatz verwendet, der die BM25-Implementierung von Haystack mit einem Embedding-basierten Ansatz kombiniert.

Die Nutzer:innenfrage wird schließlich zusammen mit den besten gefundenen Dokumenten per Jinja2 in ein Prompt Template eingefügt und an GPT-4o übergeben.

A/B Test zeigt positives Ergebnis

Um die Performance der neuen Service-Lösung messbar zu machen, hat FONIC beide Systeme in einem A/B-Test betrieben. Erste Ergebnisse zeigen, dass durch das neue System Kunden im Schnitt 10-mal weniger Interaktionen benötigen, um eine Antwort auf ihre Frage zu bekommen. Dabei bewerten doppelt so viele Nutzer die Antworten der neuen GPT-Lösung als hilfreich.

Gleichzeitig kann durch das neue System die Güte der Antworten sukzessive verbessert werden. Denn eine Auswertung der Antworten hat ergeben, dass ca. 20 % der Fragen aufgrund fehlender Informationen nicht beantwortet werden konnten. Diese Informationen konnten im Anschluss durch neue Dokumente in ElasticSearch ergänzt und damit die Qualität weiter verbessert werden.

Im Vergleich zur alten FAQ-Lösung bietet das KI-unterstützte RAG Tool bessere Antworten, reduziert den Aufwand für Nutzer:innen und erleichtert die Wartung und Erweiterung des hinterlegten Wissens.

🗓️ Termine frei

Buchen Sie Ihr Erstgespräch – unverbindlich und kostenfrei.

Yaren Sahin

Account Manager New Business